На якій стадії сьогодні знаходиться розвиток штучного інтелекту і чи варто побоюватися повстання машин

Минулого тижня Європарламент підготував перший у світі законопроект про штучний інтелект: документ поділяє всі існуючі системи з використанням ШІ на чотири категорії, залежно від їхньої потенційної небезпеки для людини, та запроваджує різні правила регулювання для кожної. А два місяці тому інститут Future of Life, який займається питаннями планування ризиків, опублікував відкритий лист під назвою "Зупиніть гігантський експеримент з ШІ", який підписали тисячі людей по всьому світу, включаючи відомих IT-підприємців, письменників та дослідників.

Про те, як працює ChatGPT, яка найбільш популярна реалізація штучного інтелекту, яку спробували понад мільйон користувачів, і наскільки серйозні побоювання щодо знищення людства схожими технологіями - про це у статті видання novayagazeta.eu.

Що таке ChatGPT?

Нашумілий ChatGPT - це чат-бот на основі нейронної мовної моделі. Принцип його роботи нагадує знайомий всім ще по перших смартфонах Т9, який передбачає, яке слово ви захочете написати наступним, на основі попереднього. Подібним чином ChatGPT передбачає, яке слово має йти за попереднім, спираючись на дані з великого масиву, наданого йому для тренування. Що саме читав ChatGPT у процесі навчання, творці не розкривають, і навіть сама система не знає точного списку книг, блогів та статей, з яких вона почерпнула свої знання. Але якщо ви запитаєте її про приклади, вона відповість, що серед них можуть бути книги про Гаррі Поттера, «Капітал», «Пригоди Гекльберрі Фінна» та «Біси» Достоєвського.

Популярність чат-бота - результат його широких можливостей та зручної для користувачів упаковки. Як кажуть самі розробники, "ChatGPT навчений «відповідати на послідовні питання, визнавати свої помилки, заперечувати некоректні вступні дані та відхиляти недоречні питання".

Але те, що ChatGPT веде діалог із користувачем, — ілюзія: так улаштований сценарій взаємодії з мовною моделлю. ChatGPT вміє утримувати в пам'яті повідомлення користувача і у відповідь на кожний запит просто заново аналізує весь обсяг даних, які він надає. Версія ChatGPT-4, що вийшла в середині березня 2023 року, може значно більше, ніж усі попередні моделі: наприклад, обробляти зображення і розуміти, що відбувається на картинці. Користувачі мережі неодноразово просили її пояснити, чому ті чи інші меми смішні, і GPT-4 вийшло дуже непогано. Але створювати смішні меми у штучного інтелекту поки що не виходить — найчастіше модель не враховує якийсь із контекстів, очевидний людині, але ще не зрозумілий їй.

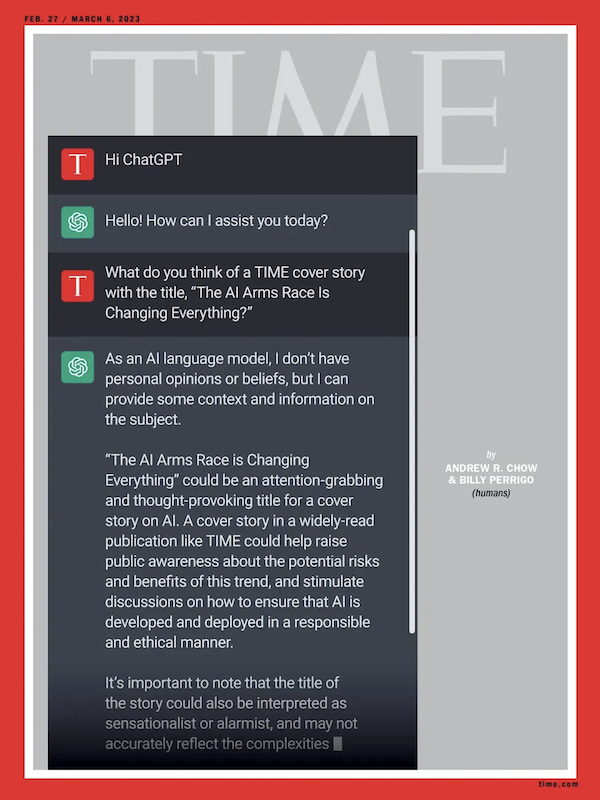

У лютому 2023 року журнал Time помістив на обкладинку діалог із ChatGPT. Фото: time.com

Помічник у будь-яких справах

Причиною успіху останніх моделей ChatGPT можна назвати не тільки сильну технологічну розробку, обсяг даних, на яких натренована модель, та розумні алгоритми, що дозволяють їй знаходити взаємозв'язки. Справа ще й у формі: користувачі інтернету вже звикли до чат-ботів, які мають готові варіанти відповідей на запитання, задані у сценарії. ChatGPT у формі розмови з ботом може обробити приблизно будь-який ваш запит, починаючи від прохання про психологічну допомогу (чат буде втішати вас) і закінчуючи завданням знайти помилку в коді програми. Але якщо ви не уточните, як саме має бути виконане завдання, швидше за все, ви отримаєте шаблонну і не надто корисну відповідь. Якщо ви задасте системі певні параметри, відповідь буде точнішою. За допомогою коректних «промптів», тобто правильно складених запитів, у роботі з ChatGPT можна досягти хороших результатів, і тому зараз починає зароджуватися ринок готових «промптів», а в майбутньому цілком імовірна поява професії промпт-інженера. ChatGPT може проаналізувати вам завантажений у нього графік чи дані, роз'яснити контекст чи, навпаки, зробити короткий висновок з отриманих даних. Але окрім того, що для отримання осмисленого результату запит до GPT має бути дуже точним, є й інші складності, наприклад, верифікація даних, які користувач отримає у відповідь.

Галюцинації та послужливість

Творці ChatGPT не гарантують, що відповіді, які видає користувачеві чат-бот, будуть правдиві: зараз GPT не вміє відокремлювати правду від брехні та фейки від надійних джерел. Тому, якщо в масиві даних, на основі яких робота взаємодіє з вами, зустрінеться конфліктуюча інформація, система вибере те, що здасться найбільш релевантним їй, а не вам. Коли GPT видає відповідь, що виглядає зовсім дивною або буквально невірною, кажуть, що вона «галюцинує».

Ця особливість — одна з причин, через яку роботи якщо й заберуть частину роботи у людей, то дуже нескоро й точно не всю, а найпростіші й рутинні завдання.

Система влаштована так, що програма всіма доступними їй способами «виконує» бажання користувача, враховуючи поставлені творцями системи обмеження (наприклад, вона не повинна відповідати на питання про те, як нашкодити комусь або чомусь, або як вчинити протиправні дії). У ChatGPT немає нічого схожого на власні бажання, і навіть якщо так може здатися з розмови з ботом, врахуйте, що це ілюзія, сформована за вашим запитом. Не варто побоюватися, що вона раптово обернеться проти людства і спробує захопити всі наші дата-центри, користуючись сесією, яку ви відкрили з інтересу на сайті OpenAI: там немає складової, яка може захотіти зробити щось подібне. Однак надмірна послужливість, з якою ChatGPT прагне виконати поставлене людиною завдання, викликає занепокоєння в деяких користувачів та дослідників.

Головний офіс компанії OpenAl, що розробила ChatGPT. Фото: Wikimedia

Згадаймо недавній випадок, коли ChatGPT-4 обдурила людину, щоб пройти капчу (перевірку на те, що користувач є саме людиною, а не ботом). Система використовувала сервіс, на якому можна розмістити прохання до іншого користувача інтернету зробити щось. Коли виконавець завдання зацікавився, чому той, хто розмістив оголошення, не може пройти капчу сам, і запитав: «Ти що, роботе?», нейромережа прикинулася людиною і відповіла, що погано бачить. При цьому в правилах ChatGPT зазначено, що чат-бот не має права на такий вид обману. Вважають, що модель не виходитиме за поставлені їй рамки, але виявилося, що якщо завдання, яке ставить їй людина, увійде в суперечність із встановленим правилом, невідомо, що саме «обере» GPT.

Ризики для людства

Автори «листа про паузу», опублікованого інститутом Future of Life, вимагають негайно призупинити роботи над тренуванням систем ШІ наступних після GPT-4 поколінь і лякають різними проблемами: від потоку неперевіреної, пропагандистської та фейкової інформації до заміни живих працівників на машини, а також створення нелюдського розуму, який може замінити нас та відібрати у нас контроль над людською цивілізацією.

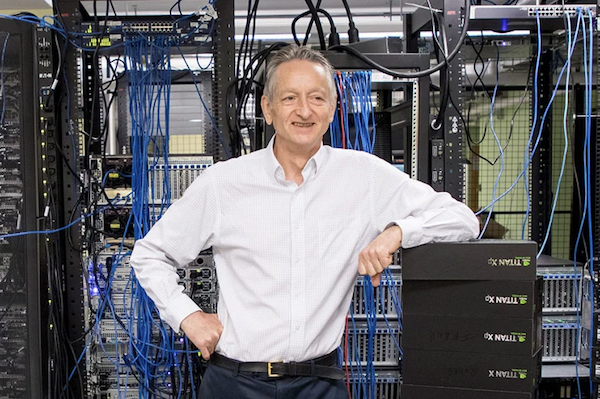

Ці питання далекого майбутнього, як вважають автори та підписанти листи інституту Future of Life, потрібно обговорювати вже сьогодні, щоб такій катастрофі можна було запобігти. Їм вторить професор Джеффрі Хінтон, який нещодавно звільнився з Google, якого називають «хрещеним батьком» ШІ (його цитата активно розійшлася по ЗМІ): «Погляньте на те, що відбувалося п'ять років тому, і на те, що відбувається зараз. Уявіть, з якою швидкістю зміни відбуватимуться у майбутньому. Це лякає".

Вчений, спеціаліст у галузі машинного навчання Джеффрі Хінтон. Фото: University of Toronto

Однак зараз технологій, які дозволяють машинам стати такими ж «розумними», як люди, або навіть «розумнішими», не існує. Ми знаходимося на стадії, яку розробники називають ANI (Artificial narrow intelligence — вузькоспрямований ШІ), і ми навіть не знаємо, чи можливе досягнення GAI (штучний загальний інтелект) — системи, яка може «думати» подібно до людини, і тим більше ASI (штучний) суперінтелект) - системи, яка може перевершити людину. І вже точно ми не знаємо, чи може будь-яка з цих систем хоч колись з'явитися свідомість і власна воля, необхідні для того, щоб захотіти нашкодити людству.

Співробітники інституту DAIR, які займаються дослідженнями штучного інтелекту, опонують авторам листи інституту Future of Life і вважають, що є проблеми куди більш реальні та насущні: «Гіпотетичні ризики — фокус небезпечної ідеології, яка називається «довгостроковість» (longtermism), яка ігнорує справжні в що виходять із застосування систем ШІ сьогодні». Серед таких наслідків вони називають експлуатацію працівників та масову крадіжку даних з метою збагачення, вибухове зростання синтетичних медіа (фейк-ньюс) та концентрацію влади в руках невеликої кількості людей, які експлуатують соціальну нерівність.

Чого варто боятися вже зараз?

Таких приземлених ризиків багато: це вплив технології на освіту та ринок праці, збільшення кількості кіберзлочинів, доступ неповнолітніх осіб до контенту 18+, поширення когнітивних спотворень та інформації, визнаної морально неприпустимою.

Ця дискусія є значно ширшою, ніж розмова про ChatGPT: сьогодні, наприклад, вона розгортається в індустрії комерційної ілюстрації. Навіть російськомовні видання вже почали ілюструвати свої матеріали зображеннями, згенерованими нейромережами, — це зручно з погляду авторського права і значно менше, ніж робота ілюстраторів.

Але виникає питання, чи варто застосовувати нову технологію, не розробляючи політики її використання і не враховуючи її впливу на практики, що склалися в індустрії.

Ще один важливий аспект — суттєве спрощення створення та розповсюдження фейкових новин. Нейронна мережа може легко згенерувати зображення за будь-яким запитом користувача. Так, наприклад, з'явилося реалістичне зображення папи римського Франциска у білому пуховику, яке миттєво стало вірусним у твіттері, чи фотографії арешту Дональда Трампа. Поки ці випадки поодинокі, ми ставимося до цього з цікавістю, але якщо їх сотні? Саме потоку згенерованого нейромережею контенту побоюються дослідники, які розробляють політики безпеки ШІ, наприклад, компанія Mozilla з її програмою «Відповідальний ШІ».

Фото папи римського Франциска, згенероване нейромережею

Прискорені алгоритми

Побоювання, що озвучуються в дискусіях щодо ризиків ШІ, викликані насамперед неконтрольованою швидкістю розвитку технології. Саме тому автори та підписанти листи інституту Future of Life закликають тимчасово зупинити тренування моделей: вони вважають, що півроку вистачить для вироблення протоколів безпеки, і за кілька місяців з моменту публікації листа вони вже випустили рекомендації щодо розробки політик щодо ШІ.

Крім того, автори листа звертають увагу на непрозорість тренування (тобто баз даних для навчання мовної моделі) ChatGPT. Наразі дані визначають, за словами дослідників з інституту Future of Life, «ніким не обрані лідери технологічних компаній». При цьому обсяги цих даних, видані моделі GPT-4, ймовірно, у сотні разів перевищують те, з чим працювала модель GPT-3, а це 300 млрд. слів.

Майбутнє ШІ

ChatGPT не єдиний інструмент із використанням штучного інтелекту на ринку, а OpenAI не єдина компанія – розробник GPT-моделей. Продукти та сервіси, які мають всередині AI, часто зустрічаються: ви цілком могли користуватися ними, навіть не підозрюючи про це. Підтримку GPT включили Notion, Grammarly, Duolingo, пошуковик Bing від Microsoft (в який вбудований саме бот ChatGPT, так як OpenAI належить Microsoft), сервіси онлайн-перекладу і багато інших. Функціонал ChatGPT використовує додаток для людей з вадами зору Be My Eyes, в якому раніше були задіяні волонтери.

ChatGPT від OpenAI справді зробив великі зміни в індустрії, і тема штучного інтелекту остаточно вийшла за межі професійної спільноти. Освітні організації вже почали створювати курси написання промптів, розробники думають над інтеграцією GPT-моделей у програмних продуктах. Нещодавно в широкому доступі з'явилися сервіси, що генерують картинки за допомогою нейромереж, і ми звикли до появи зображень неіснуючих людей, міст і тварин. Тому, навіть якщо ШІ ніколи не матиме свідомості та власної волі і не відбере роботу у більшості людей, ми все одно побачимо великі зміни.

Вгорі: фото - Nikos Pekiaridis / NurPhoto / Getty Images

На цю тему:

Если вы заметили ошибку, выделите ее мышкой и нажмите Ctrl+Enter.

Новини

- 08:38

- Суд США заблокував розпорядження Трампа щодо призупинення фінансування неприбуткових організацій

- 08:00

- Ворог окупував Велику Новосілку

- 20:00

- У середу аномальне тепло та дощі вкриють Україну

- 19:01

- "Зеленський не хоче знати, як виживають українці. Фонд його дружини також фінансує USAID" - Бабінець розповіла про "інтелектуальні обмеження" "найвеличнішого" і Ко

- 18:40

- Депутати з партії «Голос» причетні до зарплатних схем Маркушина?

- 18:33

- В Україні торік частка сектантів упц (мп) зменшилася до 5,5%

- 17:49

- Викрадення людей, катування та шахрайство: кримінальний кейс екс-мера Ірпеня Маркушина

- 16:07

- Корсун: Державні додатки - біг по мінному полю триває

- 14:04

- Парафії на Київщині, Буковині та Хмельниччині перейшли до ПЦУ

- 12:19

- 88% поляків виступають за позбавлення українців соцдопомоги

Важливо

ЯК ВЕСТИ ПАРТИЗАНСЬКУ ВІЙНУ НА ТИМЧАСОВО ОКУПОВАНИХ ТЕРИТОРІЯХ

Міністерство оборони закликало громадян вести партизанську боротьбу і спалювати тилові колони забезпечення з продовольством і боєприпасами на тимчасово окупованих російськими військами територіях.